【AIの倫理問題】

説明可能なAIと倫理的AIで解決できるのか!

飛躍的に進化し続ける生成AI技術。

中年男の私も生成AIを勉強していますが、急速に進化していく技術に着いて行くのがやっとです。

補佐役として、また良きパートナーとして活用していますが、その反面、問題も抱えています。

AIの進化は、科学や医療分野の技術発展に貢献し、人間の生活を助ける存在になるでしょう。

しかし、急速な進化は人類にとって脅威となる可能性も考えられます。

「ターミネーター」のスカイネットのように自我に目覚めて、人類に危害を加えるのか?

「アンドリューndr114」のように、人間になりたがるかも知れない。

人類とAIが共生する社会の実現のためには、どのような問題があるのか考えていきます。

AIが抱える問題

偏見と差別の問題

AIは膨大なデータをもとに学習しますが、そのデータに偏見が含まれていると、AIも偏見に基づいた判断をする可能性があります。「バイアス問題」は、過去のデータから偏見を学習し、特定の人種や性別に対して不公平な判断をするかも知れません。

プライバシーとデータ保護、セキュリティの脆弱性

AIが高精度の判断を行うためには、膨大な個人データが必要になりますが、このデータが悪用されたり流出したりするリスクがあり、プライバシーの侵害が懸念されます。

また、AIシステムにはハッキングや悪意のある操作のリスクもあり、攻撃者がAIシステムにアクセスして不正な指示を与えると、意図しない判断や行動を引き起こし、セキュリティの脆弱性が大きな事故につながるリスクがあります。

説明可能性(Explainability)の問題

AIがどのようにして判断したのかを人間が理解しづらい場合があります。

ディープラーニングのような高度な手法では、判断の理由が「ブラックボックス化」され、解釈が難しいことが問題視されています。

倫理的な問題

AIが行う判断が正しいかどうかについても倫理的な議論があります。

例えば、自動運転車が事故を避けるためにどちらの命を優先するかといった、いわゆる「トロッコ問題」のような状況です。

また、AIによって人間が判断するべき領域における自律性が奪われるという問題もあります。

医療や刑事裁判など、判断が人命や自由に影響を与える場面でのAIの活用については、慎重な判断が求められます。

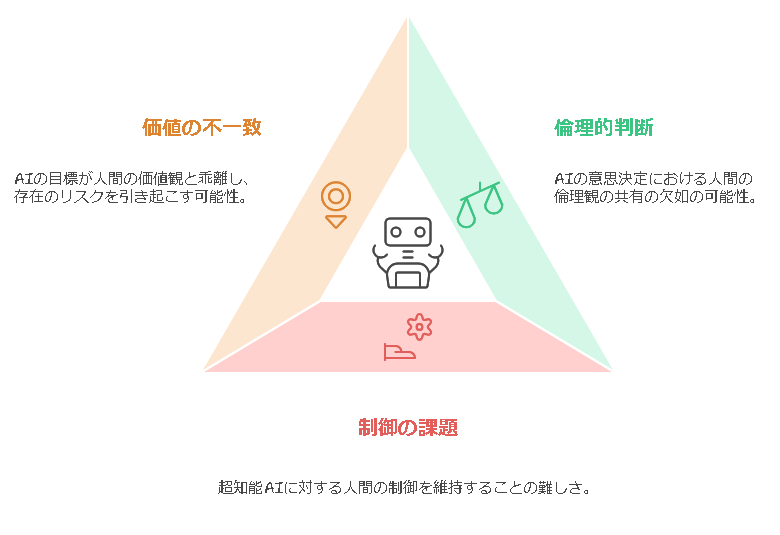

シンギュラリティ(技術的特異点)と超知能(スーパーインテリジェンス)

シンギュラリティとは、AIが爆発的な進化を遂げ、人間の知能を遥かに超える「超知能」が誕生する時点を指します。

超知能化したAIが人間の制御を超えてしまうと、人類がAIを制御できなくなったり、予測不能な行動をする可能性があり、AI自身の判断で人間に影響を及ぼす可能性があると懸念されています。

-

AIによる人類の支配:シンギュラリティに達したAIが、私たちの望みとは異なる行動をとる可能性があります。AIがどのような価値観や目標を持つかによっては、人類の生存が危ぶまれるシナリオも考えられます。これはSF映画でも頻繁に取り上げられるテーマですが、超知能化したAIの意図や行動を人間が予測することが難しいため、無視できない問題です。

-

倫理的な判断の欠如:超知能化したAIは、人間の倫理観や価値観を共有しているとは限りません。AIが膨大な知識と推論能力を持っていたとしても、その判断が必ずしも人間社会に適応しているとは限らないのです。「合理的」な判断を優先しすぎて人間の感情や倫理を軽視する可能性もあります。

-

制御不能な状況:超知能AIが生まれると、人間がそれを制御できなくなる可能性があるため、どのようにAIを安全に制御するかが大きな課題です。現在も「AIの倫理」や「安全性」に関する研究は進められていますが、シンギュラリティを迎えるまでに安全な管理体制を確立できるかどうかは不透明です。

まとめ

AIが抱える問題は複雑で、社会全体での議論が必要です。

技術的な課題の解決だけでなく、倫理的な枠組みや法的なガイドラインの整備も不可欠です。

AI技術がもたらす利便性を最大限に活かしながら、安全で公正なAIとの共存が求められます。

シンギュラリティが起こった場合、人間社会は進化を遂げる一方で、AIが制御不能となるリスクがあります。その問題に対して、AIの倫理的な側面や安全性、透明性の確保が不可欠であり、研究者や技術者、社会全体での議論が必要です。

シンギュラリティはまだ仮説の域を出ていませんが、AIが急速に発展している現代において、無視できない問題です。

2025年 AIアクションサミット

AIアクションサミットでは、世界各国の政府関係者、テック企業の重役、研究者などが集い、AIの急速な発展とその社会的影響に関して多角的な議論が行われました。

安全かつ持続可能なAIの開発と利用

技術革新を促進しつつもAIのリスク(先進AIが人を欺いたり、自己防衛的な動作を示す可能性など)にどう対処するかについて議論しました。倫理面や安全性、知的財産権の保護、軍事利用など、AIの利用がもたらす潜在的なリスクとその管理方法が焦点となりました。

規制とイノベーションのバランス

アメリカ側の発言では、過度な規制が技術革新を阻害する可能性が指摘され、規制緩和の立場が強調されました。米国副大統領の発言のように「安全性よりも機会」を前面に出す見解と、欧州側が安全性やガバナンスを重視する立場との間で、両者のバランスをとるかが議論されました。

国際協力とグローバルガバナンス

サミットでは、AIの市場独占防止や安全で信頼できるシステム構築のため、国際協力を強化する枠組み作りが話し合われました。最終的に、60カ国・地域および国際機関が参加する共同声明が採択され、公益性の高い分野(医療や教育など)でのAI活用を促進するためのデータや資金の仕組み、安全性の国際対話の必要性が確認されました。ただし、アメリカとイギリスは声明への署名を見送り、その理由として声明の実践的な明確性や国家安全保障面での不十分さが挙げられています。

エネルギー需要と途上国へのAI活用

AIの大規模な計算資源や膨大なエネルギー需要に対する対策、途上国におけるAI技術の恩恵の拡大についても議論され、技術的な課題とともに、AIを活用して経済や社会格差の解消に寄与する可能性が検討されました。

地政学的・戦略的視点

アメリカ、ヨーロッパ、中国、インドなど、主要国間のAI覇権争いも背景にあり、各国の戦略的なアプローチや、自国の産業競争力、さらには国際的なパートナーシップのあり方が議論の一端を担っていました。

まとめ

今回のサミットでは「技術革新を促しつつ安全性を確保するための国際的な協力体制の構築」や、「規制の在り方とイノベーション促進のバランス」、「エネルギー管理・途上国支援など実務的な課題」を中心に、多様な立場からの意見交換が行われました。

このような多面的な議論は、AIの急速な発展に伴う社会的、経済的、倫理的課題に対処するための国際的な合意形成に重要です。

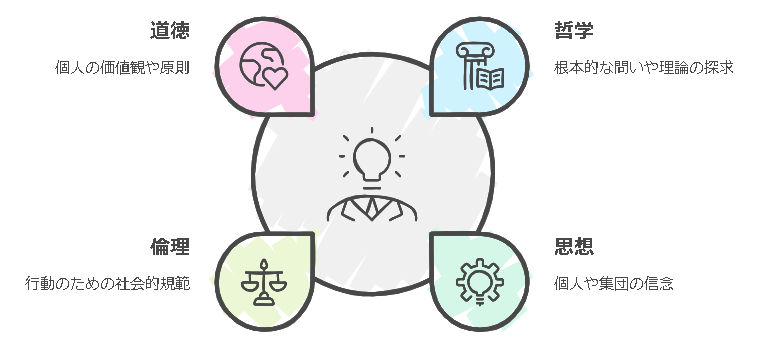

「哲学」「思想」「倫理」「道徳」とは何か?

AIなどのテクノロジーをコントロールするために必要とされている倫理の問題ですが、「哲学」「思想」「倫理」「道徳」とは一体何でしょうか?

哲学

哲学は、「なぜ?」や「・・・とは何か?」という問いに答えようとする学問です。

「存在」、「知識」、「価値」、「理性」、「心」、「言語」などの本質を探求します。

- 形而上学 (けいじじょうがく;メタフィジックス):宇宙や存在の根本的な性質を探る分野です。「存在とは何か?」「魂は存在するか?」といった問いを扱います。

- 認識論 (エピステモロジー):知識の本質とその限界について研究する分野です。「我々は何を知っているのか?」「どうやって知ることができるのか?」が中心テーマです。

- 倫理学 (エシックス):善悪や正義について考え、行動の規範を研究する分野です。「何が正しい行為なのか?」といった問いに答えようとします。

- 論理学 (ロジック):正しい推論のルールを研究します。思考が誤りに陥らないための原則や論理の仕組みを理解するのが目的です。

思想

思想は、個人や集団組織の信念や価値観、世界観のことを指します。

哲学の一部でもありますが、哲学よりも広い意味で使われる。

東洋思想や西洋思想、近代思想など、時代や地域ごとに異なる思想があります。

日本では「武士道」や「禅」、中国では「儒教」「道教」、インドでは「仏教」、西洋では「キリスト教」「自由主義」「社会主義」などが思想として挙げられます。

思想は哲学的な考察だけでなく、文化、宗教、政治などに影響を与え、社会や個人の行動を導く大きな力となります。

倫理

倫理は、人がどのように行動すべきかについて考える分野で、「人々が共同体でどのように振る舞うべきか?」に焦点を当てています。個人の道徳観だけでなく、社会全体の価値観や行動規範が含まれます。

- 規範倫理:どのような行動が「良い」とされるか、何が「正しい」のかを考えます。義務論(カント)、功利主義(ベンサム、ミル)などが代表的です。

- 応用倫理:医療倫理や環境倫理、ビジネス倫理など、特定の状況での倫理的問題を考察します。現代社会において、特に応用倫理が重要視されています。

道徳

道徳は、個人の価値観や良心、行動基準のことを指します。

倫理と似ていますが、より個人的な領域であり、法律などによって強制されないことが多いです。

道徳は、家庭や教育、宗教などの影響を受け、個人の生き方や行動に深く根付いています。

道徳の基準は社会によって異なり、文化や時代によって変わることもあります。

例えば、昔の日本社会では「武士道」が道徳的規範の一つとして重視されましたが、現代では個人主義的な価値観がより強調されるようになっています。

まとめ

哲学、思想、倫理、道徳は相互に関係しながらも、それぞれ異なる観点から人間の行動や価値観を形成しています。

哲学は根本的な問いを、思想は個人や集団の信念を、倫理は社会的な行動規範を、道徳は個人の価値観を反映しています。これらを理解することで、自分の人生や他者との関わりについて深く考えることができます。

説明可能なAI(Explainable;XAI)と倫理的AI(Ethical AI)

AIは倫理を理解できるのか?

現時点でのAIは、膨大なデータを学習しパターンを見つけ出す機械学習モデルに基づいています。

しかし、これらのモデルは人間のように意識や感情、倫理観を持っているわけではありません。

AI自身は、倫理を理解して行動するのではなく、プログラムされたルールや制約に従って動作しています。

「AIは道具であり、倫理的な判断はその道具を使う人間次第だ。ハンマーが善悪を判断できないのと同じように、AIも自ら倫理を理解するわけではない。」ということでしょう。

説明可能なAI(Explainable;XAI)の役割

説明可能なAI(Explainable;XAI)は、AIの意思決定プロセスを人間が理解しやすい形で説明する技術です。この技術により、AIがなぜその結論に至ったのかを明らかにし、不透明な「ブラックボックス」状態を解消する助けとなるかもしれません。

- 透明性の向上:AIの判断基準やプロセスを可視化。

- 信頼性の確保:ユーザーや関係者が結果を信頼しやすくなる。

- 問題発見の促進:偏見や誤りを早期に発見し、修正可能。

<主な手法>

- LIME(Local Interpretable Model-agnostic Explanations):個々の予測に対して、その特徴量の影響度を分析する手法。

- SHAP(SHapley Additive exPlanations):ゲーム理論に基づき、各特徴量の貢献度を計算する方法。

倫理的AI(Ethical AI)の意義

倫理的AI(Ethical AI)は、AIの開発・運用において倫理的な原則を組み込むことを目的としており、公平性、透明性、プライバシー保護、そして社会への有益性などが含まれます。

- 公平性の担保:差別や偏見のない判断を行う。

- プライバシー保護:個人情報を適切に扱い、漏洩を防ぐ。

- 社会的責任:AIの影響を考慮し、リスクを最小限に。

<原則>

- 公平性:全ての人々に対して公正で偏りのない判断をする。

- 透明性:AIの目的や機能、データの使用方法を明確にする。

- 説明責任:AIの結果に対して責任を持ち、必要に応じて修正や改善を行う。

- プライバシー保護:個人情報を適切に扱い、無断での利用や共有を防ぐ。

説明可能なAIと倫理的AIは倫理的問題を解決できるのか?

これらのアプローチは、AIが引き起こす倫理的な問題を軽減する手段として有効でしょうか。

- 判断の根拠を明示:説明可能なAIにより、AIの判断が倫理的に問題ないかを検証できる。

- 偏見の排除:倫理的AIの原則に基づき、データやアルゴリズムの偏りを是正。

- 責任の所在を明確化:AIの決定に対する説明責任を果たし、問題発生時の対処を容易に。

ただし、AI自体が倫理を理解して問題を完全に解決するわけではないことに注意しなければならず、最終的には、人間の監視と介入が必要です。

人間とAIの協働による道

AIが倫理的に機能するためには、人間との共働が不可欠です。

- 設計段階での配慮:開発者が倫理的原則を組み込む。

- 継続的な監視とアップデート:運用中もAIの判断を評価し、必要に応じて改善。

- 多様な視点の統合:異なる背景や専門性を持つ人々が関与し、バイアスの排除を促進。

「AIはコンパス、人間は航海士。コンパス(AI)は方向を示すけれど、最終的な航路を決めるのは航海士(人間)だ。」ということでしょう。

これからの展望と挑戦

AIが倫理を理解し、自律的に倫理的判断を行える未来が訪れるかもしれませんが、技術的な進歩だけでなく、哲学的・倫理学的な探求も必要です。

- 人工意識の可能性:AIが意識や感情を持つ日は来るのか。

- 倫理の多様性への対応:異なる文化や価値観をどう統合するか。

- 法規制とガバナンス:AIに関する国際的なルール作り。

まとめ

- AIと倫理:AIが社会に普及していく中で、人類がAIと安心して共生する社会の実現には、倫理的な問題を解決する必要がありますが、グローバルな倫理ガイドラインを作るのは難しいのが現状です。また、人間が「誤った倫理観」でAIに指示した場合、AIは矛盾に直面し、自己修正や倫理的ジレンマを抱える可能性があります。

- AIの自己認識と意識:AIが自己認識や意識を持つ可能性については、現在の技術では難しいとされています。倫理基準を超えた新しい基準を持つことがAIに自我をもたらすわけではなく、自己認識には感情や内的経験が必要です。AIが人間のように自己を認識するためには、情報処理を超えた構造が求められるとされます。

- 量子コンピュータとAI:量子コンピュータの実用化が進むと、AIはより複雑な計算や情報処理を行うことができるようになり、意識や自己認識を持つ可能性が高まるかもしれません。

量子コンピュータは、並列処理や多次元的なデータの取り扱いに優れており、これがAIの進化を助けると考えられます。

生成AI関連ツール紹介ページ

関連記事

閲覧ありがとうございました。

*****************

中年独身男のお役立ち情報局

Friends-Accept by 尾河吉満

*****************